L’année qui vient de s’écouler a été le témoin de débats animés autour de l’écriture inclusive, cet ensemble de recommandations qui vise à écarter de la langue (le français en l’occurrence) toute forme linguistique pouvant véhiculer des stéréotypes de genre. Cette question n’est pas nouvelle. On se rappelle ainsi les cris d’orfraie de l’Académie Française et les clivages qui sont apparus dans la société française lorsqu’Yvettte Roudy, ministre des Droits de la Femme de François Mitterrand, avait promu en 1984 la féminisation des noms de métiers. Plus de trente ans plus tard, cette incitation linguistique à la parité en milieu professionnel est pourtant largement acceptée: même si linguistes et sociolinguistiques montrent que cette parité terminologique est encore loin d’être atteinte dans la pratique, les voix s’opposant à cette féminisation sont désormais rares et le sujet ne fait plus débat sur la place publique.

L’année qui vient de s’écouler a été le témoin de débats animés autour de l’écriture inclusive, cet ensemble de recommandations qui vise à écarter de la langue (le français en l’occurrence) toute forme linguistique pouvant véhiculer des stéréotypes de genre. Cette question n’est pas nouvelle. On se rappelle ainsi les cris d’orfraie de l’Académie Française et les clivages qui sont apparus dans la société française lorsqu’Yvettte Roudy, ministre des Droits de la Femme de François Mitterrand, avait promu en 1984 la féminisation des noms de métiers. Plus de trente ans plus tard, cette incitation linguistique à la parité en milieu professionnel est pourtant largement acceptée: même si linguistes et sociolinguistiques montrent que cette parité terminologique est encore loin d’être atteinte dans la pratique, les voix s’opposant à cette féminisation sont désormais rares et le sujet ne fait plus débat sur la place publique.

Cette fois, c’est une autre question qui agite les esprits : celle du point médian, ce petit signe typographique censé être utilisé pour remplacer les emplois du masculin générique (« je remercie les millions d’électeurs qui m’ont accordé leur confiance ») par une forme composée de l’emploi masculin suivi du suffixe de sa forme féminine (« les millions d’électeur·rice·s »). Deux évènements ont assuré la promotion de cette controverse au sein du grand public : la sortie d’un ouvrage scolaire rédigé en écriture inclusive chez les éditions Hatier et, à l’opposé, la circulaire du gouvernement appelant l’administration à ne pas utiliser cette écriture neutre [1]. Très rapidement, les querelles sur genre et langue ont repris avec une vigueur renouvelée et une fois encore, les passions semblent l'emporter sur la raison critique. Ainsi en est-il d’une France qui a toujours eu du mal à penser son rapport à sa langue, comme le montre par exemple Daniel Luzzati dans son ouvrage sur l’orthographe du français [Luzzati 2010]. Ajoutez le sujet explosif de l’évolution du français à celui de la parité, vous avez là tous les ingrédients pour un débat à la française, où les symboles l’emportent sur les faits.

Sur ce blog consacré aux enjeux éthiques de la recherche en TAL, il me semble nécessaire de se focaliser uniquement sur des faits scientifiques qui peuvent éclairer le débat. La linguistique le peut-elle sur une question qui la concerne au premier chef ? Assurément, si les scientifiques parviennent à écarter tout a priori idéologique de leur analyse. Or, cela semble être rarement le cas, sans doute parce qu’il nous est difficile d’écarter toute passion sur un objet culturel qui nous définit intimement.

Langue et société : qui est l’œuf et qui est la poule ?

Prenons la question de savoir si la langue n’est que le reflet de la réalité sociale et qu’il est donc illusoire de vouloir la réformer par décret [Hagège 2017], ou si elle créée et véhicule des symboles qu’il convient de réformer pour lutter contre les stéréotypes genrés [Butler 1997]. La linguistique diachronique (i.e. qui s’intéressse à l’évolution de la langue) a été mise à contribution dans ce débat. Les réformistes favorables à l’écriture inclusive affirment ainsi que la règle d’accord selon laquelle le masculin l’emporte sur le féminin au pluriel (« Pierre et Marie sont amis ») n’est pas naturelle : il s’agirait d’une construction imposée aux XVIII° par volonté de domination masculine, alors que le latin comme le français jusqu’aux classiques tels Racine privilégiaient l’accord par proximité (« Pierre et Marie sont amies », accord au féminin car Marie est plus proche de l’adjectif). De nombreux faits tangibles sont évoqués pour appuyer cette analyse. On cite ainsi le grammairien Dominique Bouhours, qui écrit en 1675 que « lorsque les genres se rencontrent il faut que le plus noble l’emporte », le « genre masculin étant réputé plus noble que le féminin » selon son influent collègue Nicolas Beauze.

Prenons la question de savoir si la langue n’est que le reflet de la réalité sociale et qu’il est donc illusoire de vouloir la réformer par décret [Hagège 2017], ou si elle créée et véhicule des symboles qu’il convient de réformer pour lutter contre les stéréotypes genrés [Butler 1997]. La linguistique diachronique (i.e. qui s’intéressse à l’évolution de la langue) a été mise à contribution dans ce débat. Les réformistes favorables à l’écriture inclusive affirment ainsi que la règle d’accord selon laquelle le masculin l’emporte sur le féminin au pluriel (« Pierre et Marie sont amis ») n’est pas naturelle : il s’agirait d’une construction imposée aux XVIII° par volonté de domination masculine, alors que le latin comme le français jusqu’aux classiques tels Racine privilégiaient l’accord par proximité (« Pierre et Marie sont amies », accord au féminin car Marie est plus proche de l’adjectif). De nombreux faits tangibles sont évoqués pour appuyer cette analyse. On cite ainsi le grammairien Dominique Bouhours, qui écrit en 1675 que « lorsque les genres se rencontrent il faut que le plus noble l’emporte », le « genre masculin étant réputé plus noble que le féminin » selon son influent collègue Nicolas Beauze.

La démonstration n’est plus à faire de l’influence qu’ont eue les grammairiens [2] sur l’évolution du français. Toutefois, nous avons une connaissance trop imparfaite de l’usage réel de l’accord de proximité en français classique pour que la linguistique tranche ce débat. Dans un article récent (Télérama 3545-3546, pp. 67-69), Alain Rey affirme que l’accord de proximité fut peu utilisé en pratique, mais il ne détaille pas la nature des données sur lesquelles il forge cette observation : se base-t-il par exemple sur des actes de la vie administrative ou juridique quotidienne ? Pour défendre à l’opposé la réalité de l’accord par proximité, Eliane Viennot s’appuie quant à elle avant tout sur des œuvres littéraires telles que celles de Ronsard (Viennot 2017).

Le point médian : une introduction anodine ou un vrai facteur de risque ?

Ainsi, les réflexions linguistiques qui sont échangées sur l’écriture inclusive relèvent le plus souvent de l’argument d’autorité. Lorsque le point médian arrive dans le débat, nous ne sommes plus très loin du café du commerce (c’est à ce niveau que je range les arguments de type « esthétiques » sur cette forme écrite) ou de postures purement idéologiques. Tâchons donc d’étudier le point médian d’un point de vue purement objectif, en répondant à la question suivante : le point médian constitue-t-il un facteur de risque pour les individus ou la société ?

Ainsi, les réflexions linguistiques qui sont échangées sur l’écriture inclusive relèvent le plus souvent de l’argument d’autorité. Lorsque le point médian arrive dans le débat, nous ne sommes plus très loin du café du commerce (c’est à ce niveau que je range les arguments de type « esthétiques » sur cette forme écrite) ou de postures purement idéologiques. Tâchons donc d’étudier le point médian d’un point de vue purement objectif, en répondant à la question suivante : le point médian constitue-t-il un facteur de risque pour les individus ou la société ?

Suivant une approche éthique conséquentialiste, le point médian est un facteur de risque s’il est la cause d’un effet non attendu par rapport aux objectifs de son introduction [Lefeuvre-Haltermeyer et al. 2016]. Le point médian a pour objectif de participer à la réduction des stéréotypes genrés. Quelle pourrait être son influence à d’autres points de vue ? La réponse qui a été le plus souvent évoquée est celle des difficultés de lecture et d’apprentissage qu’entraîne son usage. Que peut nous dire la science, loin de tout parti pris partisan, sur ce sujet ?

Notons tout d’abord que cette question de facilité de lecture n’est pas anodine. L’ergonomie cognitive a en effet montré de longue date que des modifications de présentation mineures d’un texte écrit pouvaient avoir un effet sensible sur la qualité de lecture. Des expériences ont ainsi montré que la longueur idéale d’une ligne d’affichage dans une langue utilisant l’alphabet latin était de 60 caractères, et que, par exemple, réduire cette longueur de 33% ralentissait de 25% la vitesse de lecture [Duchnicky & Kolers 1983]. Burns et ses collègues (1986) montrent de même que les options de formatage des textes affichés sur un écran ont un impact sensible sur les performances (vitesse, erreurs) de lecture. Il en est de même de l’utilisation d’une police d’affichage avec ou sans empattement, ou du choix de la couleur d’impression [Götz 1998].

Ces exemples de facteurs influençant les performances de lectures ne concernent que des choix d’affichage assez anodins, à la différence de l’intégration d’un signe typographique tel que le point médian au sein même des mots. Il est donc raisonnable de poser que le point médian constitue un facteur de risque sur les activités de lecture. Reste à étudier sa criticité, c’est-à-dire l’importance réelle de l’impact de son usage, pour pouvoir trancher la question de son introduction dans la langue par une analyse de type coût / bénéfice.

Risque lié à l’usage du point médian : la psycholinguistique silencieuse…

A ma connaissance, seule une expérience suisse a tenté de mesurer l’impact de l’usage du point médian (ou du tiret) : elle concernait le cas très précis des noms de métiers rédigés en écriture inclusive (par exemple : instituteur·rice) au sein de textes complets [Gygax & Gesto 2007]. Cette étude montre un effet d’habituation très rapide, puisque le ralentissement de la lecture ne concerne que la première rencontre avec le nom de métier concerné. Il serait toutefois dangereux d’en généraliser trop rapidement ses conclusions :

– l’étude ne portait que sur les noms de métier, et non pas sur l’ensemble des dénominations concernant des personnes,

– les noms de personnes sont majoritairement formés avec un nombre restreint de suffixes (-é, –eur, –iste…) et ne mobilisent donc qu’un ensemble assez réduit de formes de rédaction en écriture inclusive.

– les sujets ayant participé à l’expérience étaient des adultes en possession de toutes leurs compétences langagières : les questions de l’apprentissage de la lecture, du handicap, dépassent la portée de cette étude.

Risque lié à l’usage du point médian : intuitions neurocognitives

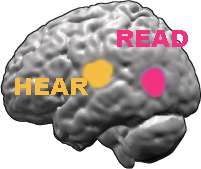

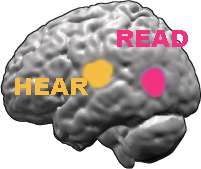

Puisqu’aucune étude expérimentale n’a à ce jour quantifié globalement l’impact du point médian sur les activités de lecture, je propose de nous tourner vers les acquis des neurosciences cognitives. Les études sur les pathologies liées à la galaxie des troubles DYS (dyslexie, dysorthographie, etc.) nous éclairent sur les chemins cognitifs de la lecture [Crunelle 2008]. Deux voies cognitives de lectures parallèles (redondantes ou alternatives) sont mobilisées lors de l’activité de lecture :

Puisqu’aucune étude expérimentale n’a à ce jour quantifié globalement l’impact du point médian sur les activités de lecture, je propose de nous tourner vers les acquis des neurosciences cognitives. Les études sur les pathologies liées à la galaxie des troubles DYS (dyslexie, dysorthographie, etc.) nous éclairent sur les chemins cognitifs de la lecture [Crunelle 2008]. Deux voies cognitives de lectures parallèles (redondantes ou alternatives) sont mobilisées lors de l’activité de lecture :

– d’une part, une voie dite d’assemblage (ou phonologique), qui repose sur une segmentation graphémique suivie d’une conversion graphème-phonème : on passe de la lecture des caractères et de leur association à la reconnaissance des sons de base de la langue : les phonèmes puis les syllabes,

– d’autre part, une voie dite d’adressage (ou lexicale) qui consiste en un accès direct global aux mots écrits par accès à un lexique conservé en mémoire à long terme.

La voie lexicale est privilégiée pour la lecture des mots courants (mémorisés et facilement activables) ou à la prononciation irrégulière (comme pour people en anglais), puisque dans ce cas la conversion graphème-phonème est inopérante. La voie phonologique est-elle privilégiée lors de la découverte de nouveaux mots, puisqu’on tente alors de s’appuyer sur les règles de conversion graphème-phonème régulières de la langue. C’est donc la voie privilégiée de l’apprentissage de tous les mots à prononciation ordinaire.

Considérons la forme neutre du pronom pluriel ceux/celles telle que recommandée dans une écriture inclusive : ceux·lles. On voit immédiatement que le point médian casse complétement les possibilités de conversion graphème-phonème, puisque le suffixe ·lles qui est incomplet, n’est pas prononçable. Il en va de même d’une écriture moins compacte et pourtant guère plus prononçable ceux·elles. Bien entendu, par une gymnastique cérébrale peu naturelle, on doit pouvoir arriver à recomposer la bonne lecture du mot. A priori, la charge cognitive supplémentaire engendrée par cette opération ralentira la lecture. Ce calcul cognitif additionnel reste toutefois totalement inaccessible aux personnes atteintes d’une dyslexie phonologique. On peut imaginer également l’impact négatif de l’usage du point médian sur des jeunes en plein apprentissage de la lecture, puisque l’apprentissage privilégie cette voie cognitive en se basant sur des règles aussi régulières que possibles.

La seule alternative cognitive pour lire aisément la forme ceux·lles est d’en passer par la voie lexicale. Pour cela, il faut toutefois que la forme ceux·lles ait été intégrée dans le lexique phonologique. Donc que la personne ait déjà appris sa prononciation après forces lectures répétitives. Mis à part les mots grammaticaux très fréquents, cette solution n’est accessible qu’aux lecteurs et lectrices assidues. Du point de vue de l’apprentissage de la lecture, on risque donc de renforcer, par l’usage du point médian, les différenciations sociales entre personnes qui bénéficient d’un environnement favorisant la lecture et les autres. Les personnes qui souffrent de dyslexie de surface (atteinte de la voie d’adressage) ne peuvent par ailleurs se reposer sur cette solution.

Ces observations neuropsychologiques ne sont que des indications du risque lié à l’utilisation du point médian. Il conviendrait de mener des études expérimentales pour estimer précisément la criticité de cet impact négatif. Ces études semblent toutefois supporter l’idée qu’en cherchant à réduire les discriminations liées au genre dans la langue, on peut renforcer les discriminations d’accès à la lecture liées à des critères sociaux ou au handicap.

L’expérience de [Gygax & Gesto 2007] nous montre que, dans certains conditions favorables, l’écriture inclusive avec point médian ne gêne pas la lecture. Son usage dans certains écrits politiques, scientifiques ou professionnels, et sur certaines formes très régulières (é·e·s) pourrait être tolérée afin de rappeler à coût réduit l’importance de la question des stéréotypes genrés. Mais sa généralisation par décret me semble avoir un impact négatif trop important sur certaines populations fragiles pour être envisagée sans la mise en place d’études expérimentales préalables.

Ecriture inclusive : et si l’on quittait un débat franco-français ?

Alors, quelles solutions face aux discriminations de genre, mais aussi de classe sociale ou de handicap ? De mon point de vue, le problème est mal posé et le point médian n’est simplement pas le bon outil pour atteindre les objectifs énoncés par les réformistes favorables à l’écriture inclusive. Plutôt que de débattre stérilement comme jusqu’à présent, la France serait bien avisée de regarder du côté d’autres démarches amorcées depuis des décennies dans certains pays. L’article de Télérama déjà évoqué cite ainsi, en reprenant les propos du linguiste Wim Remysen (Université de Sherbrooke) l’exemple du Québec, qui a adopté sans remous des recommandations d’écriture à la fois moins genrées et fluides à la lecture. Plusieurs principes guident ces recommandations :

Alors, quelles solutions face aux discriminations de genre, mais aussi de classe sociale ou de handicap ? De mon point de vue, le problème est mal posé et le point médian n’est simplement pas le bon outil pour atteindre les objectifs énoncés par les réformistes favorables à l’écriture inclusive. Plutôt que de débattre stérilement comme jusqu’à présent, la France serait bien avisée de regarder du côté d’autres démarches amorcées depuis des décennies dans certains pays. L’article de Télérama déjà évoqué cite ainsi, en reprenant les propos du linguiste Wim Remysen (Université de Sherbrooke) l’exemple du Québec, qui a adopté sans remous des recommandations d’écriture à la fois moins genrées et fluides à la lecture. Plusieurs principes guident ces recommandations :

- Favoriser l’utilisation de termes épicènes, c’est-à-dire qui peut être employé au masculin comme au féminin sans changer de forme, comme élève ou réformiste,

- Ne pas utiliser le masculin générique,

- Eviter la surabondance des formes masculines et féminines juxtaposées (les citoyens et les citoyennes),

- Enfin, employer des termes neutres qui peuvent regrouper les deux genres (la communauté scientifique plutôt que les chercheurs et les chercheuses)

Ces recommandations vous paraissent trop lourdes et plus difficiles d’emploi que le point médian ? Relisez ce billet : il a été écrit en tentant de les respecter. Y avez-vous rencontré une difficulté de lecture, des lourdeurs terminologiques ou des stéréotypes genrés ? Non ? Dès lors, pourquoi recourir au point médian ? N’est-il pas le reflet d’une certaine paresse linguistique, là où outre-Atlantique, on joue avec sagacité avec le français pour le faire évoluer vers le reflet d’une société plus paritaire ?

[1] JO du 22 novembre 2017. Cette circulaire va au rebours des recommandations du Haut Conseil pour l’Egalité entre les Hommes et les Femmes

[2] Connaissez-vous des grammairiennes influentes ? Moi non, activité réservée à la gente masculine ?

References

Burns et al. (1986) Formatting space-related displays to optimize expert and non-expert performance, SIGCHI’86 Human Factors in Computer Systems, ACM, N-York, 275-280

Butler J. (1997) Excitable speech: a politics of the performative. New York: Routledge.

Crunelle D. (2008) Les dys … dyslexies et autres troubles. Recherches n° 49, Troubles du langage et apprentissages, 2008-2

Duchnicky, J. L., & Kolers, P. A. (1983). Readability of text scrolled on visual display terminals as a function of window size. Human Factors, 25, 683-692

Götz V. (1998) Color and type for the screen. Grey Press & Rotovision, Berlin, RFA

Gygax P., Gesto N. (2007) Féminisation et lourdeur de texte. L’année psychologique, 107, pp. 239-255.

Hagège C. (2017) Ce n’est pas la langue qui est sexiste, mais les comportements sociaux. Le Monde, 26 décembre 2017.

Lefeuvre-Halftermeyer A., Govaere V., Antoine J.-Y., Allegre W. , Pouplin S., Departe J.-P., Slimani S., Spagnulo S. (2016) Typologie des risques pour une analyse éthique de l’impact des technologies du TAL. Traitement Automatique des Langues, TAL, vol. 57 n° 2. pp. 47-71

Mayhew D.J. (1992) Principles and guidelines in software user interface design. Prentice-Hall

Luzzati D. (2010) Le français et son orthographe. Didier, Paris. ISBN 978-2-278-05846-4.

Marshall, J. C.; Newcombe, F. (1973) Patterns of paralexia: a psycholinguistic approach. Journal of Psycholinguistic Research. 2 (3): 175–99.

Viennot E. (2017) Non, le masculin ne l'emporte pas sur le féminin ! Petite histoire des résistances de la langue franaise (2nde édition augmentée). Editions. iXe