Il y a presque quatre ans, nous abordions sur ce blog le sujet de la diversité dans la communauté du traitement automatique de la langue. Il en ressortait que les données pour observer la diversité étaient difficiles à trouver et qu’une grande marge d’amélioration existait. Ces points restent d’actualité.

La question du genre en TAL

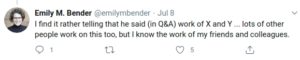

Cette année, la conférence ACL a sollicité des réflexions sur sur les progrès du domaine et sur les directions à prendre en tant que communauté. Dans ce cadre, Saif Mohammad du Conseil National de Recherches au Canada a réalisé une étude bibliographique sur les articles publiés dans l’anthologie ACL [1]. Les résultats suggèrent une disparité persistante dans la présence des femmes parmi les auteur·e·s d’articles (29,7 %) et dans les taux de citation : en moyenne, les articles ayant un homme comme premier auteur sont cités plus de 50 fois, contre 37 seulement pour les articles ayant une femme comme première autrice. Si l’article ne propose pas d’explication à ces observations, des commentaires observés sur Twitter suite à la deuxième présentation invitée de la conférence illustrent ce phénomène :

Les conversations autour de l’article font état de fortes réserves éthiques sur la méthodologie utilisée pour caractériser le genre. L’article distingue les genres homme/femme et s’appuie sur des listes issues du recensement et d’études précédentes pour distinguer les prénoms féminins masculins et épicène/inconnu. Les critiques font état de deux problèmes majeurs. Tout d’abord, l’utilisation d’une caractérisation binaire a pour conséquence une négation de l’existence des genres non binaires. Il en découle une atteinte à la représentation des personnes par l’utilisation d’une méthode automatique de classification en genre, qui repose sur l’hypothèse que le genre peut être déterminé par des caractéristiques observables plutôt que par le ressenti des personnes. Cette critique s’applique à toute méthode automatique de reconnaissance du genre, telle que la reconnaissance de la parole ou l’analyse d’image, qui a déjà fait l’objet d’une étude spécifique [2].

Il est suggéré dans la conversation que la seule méthode éthiquement acceptable pour déterminer le genre est de demander directement aux personnes concernées comment elles s’identifient. Cela peut s’avérer difficile à réaliser sur une large échelle, en particulier dans le temps (absence de réponse des personnes, décès…).

Ces réflexions incitent à prendre du recul pour envisager que si ce qui n’est pas compté ne compte pas, comment considérer ce qui ne peut pas être compté?

Biais implicite

L’utilisation inadéquate de méthodes de classification en genre peut s’expliquer par la prévalence dans la culture occidentale de la représentation binaire du genre. En effet, les individus sont sujets au biais implicite de l’absence de genre non binaire véhiculé culturellement.

Dans le cadre de l’atelier Ethique et TRaitemeNt Automatique des Langues (ETeRNAL) à Nancy en Juin, nous avons proposé une introduction à la notion de biais implicite avec la participation à un test d’association implicite élaboré par le collectif Project Implicit. Cette expérience a montré que la distribution des résultats des participants ETeRNAL au test d’association implicite « Gender and Science » reflète celle observée sur un grand nombre de participants du Project Implicit : le genre masculin est majoritairement associé avec la discipline scientifique alors que le genre féminin est majoritairement associé avec la discipline artistique (61 % des participants). Les participants d’ETeRNAL indiquent cependant que leur conviction consciente est qu’il n’y pas d’association entre genre et discipline (95 % des participants).

L’importance de la prise de conscience de l’existence de biais implicites, en particulier genrés, a été démontrée par une étude récente sur les pratiques des commissions de recrutement du CNRS [3]. Cette étude montre que les commissions ayant reçu une formation sur les biais implicites aboutissent à des recrutements moins biaisés que les commissions n’ayant pas bénéficié de la formation.

Ainsi, en tant que communauté scientifique, il convient de ne pas négliger ces questions et de continuer nos efforts pour favoriser et valoriser la diversité.

Références:

[1] Mohammad S. Gender Gap in Natural Language Processing Research: Disparities in Authorship and Citations. Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics, pages 7860–7870

[2] Keyes O. 2018. The Misgendering Machines: Trans/HCI Implications of Automatic Gender Recognition. Proc. ACM Hum.-Comput. Interact. 2, CSCW, Article 88 (November 2018), 22 pages.

[3] Régner I, Thinus-Blanc C, Netter A, Schmader T, Huguet P. Committees with implicit biases promote fewer women when they do not believe gender bias exists. Nat Hum Behav 3, 1171–1179 (2019).