Nous passons notre temps à courir. D’une activité à l’autre, d’une vie à l’autre, d’un désir à l’autre. Nous célébrons peu, car les réalisations doivent se succéder, à un rythme de plus en plus soutenu. Pour obtenir un poste. Pour trouver un financement. Pour faire carrière. Pour ne pas avoir à penser trop à ce que nous faisons de nos vies.

En cette nouvelle année, je nous souhaite de trouver la volonté de prendre le temps. En particulier le temps de célébrer nos réussites, le résultat de nos efforts, si peu considérés, alors que nos échecs font si souvent l’objet de d’analyses, de relectures, de signalements. Bien entendu, il est sain de faire cette démarche et si naturel pour des scientifiques… Cependant, quelqu’un m’a fait remarquer il y a peu que fêter nos réussites est tout aussi important, pour entretenir l’envie et faire vivre les collectifs.

Je souhaite donc ici célébrer le numéro spécial de la revue TAL consacré à l’éthique, publié (en ligne, gratuitement) in extremis (encore une question de temps) juste avant Noël, après plus d’un an et demi de travail :

https://www.atala.org/IMG/pdf/Book_57-2-2.pdf

Je suis fière de ce volume, sur le fonds, sur la forme, et sur ce qu’il dit de notre communauté de chercheurs/ses. C’est le premier numéro de revue centré sur le sujet, et il émane de la communauté francophone. Il a été construit grâce au travail d’un collectif très large, comprenant les rédacteurs en chef invités (Gilles Adda, K. Bretonnel Cohen et moi-même), l’un des rédacteurs en chef de la revue TAL (Jean-Luc Minel), les membres du comité de lecture (ceux listés ici et ceux du comité de rédaction de la revue TAL), les auteurs des papiers (soumis et acceptés), le comité de rédaction de la revue (CR) et la relectrice. J’ai été l’initiatrice du projet et j’en ai assuré le suivi, mais je n’étais pas seule et jamais je n’aurais pu le mener à bien sans l’aide, le conseil et l’énergie non seulement de mes co-rédacteurs en chef, mais également d’autres personnes autour (je pense en particulier aux membres du CR de ce blog).

Je suis fière de ce volume, sur le fonds, sur la forme, et sur ce qu’il dit de notre communauté de chercheurs/ses. C’est le premier numéro de revue centré sur le sujet, et il émane de la communauté francophone. Il a été construit grâce au travail d’un collectif très large, comprenant les rédacteurs en chef invités (Gilles Adda, K. Bretonnel Cohen et moi-même), l’un des rédacteurs en chef de la revue TAL (Jean-Luc Minel), les membres du comité de lecture (ceux listés ici et ceux du comité de rédaction de la revue TAL), les auteurs des papiers (soumis et acceptés), le comité de rédaction de la revue (CR) et la relectrice. J’ai été l’initiatrice du projet et j’en ai assuré le suivi, mais je n’étais pas seule et jamais je n’aurais pu le mener à bien sans l’aide, le conseil et l’énergie non seulement de mes co-rédacteurs en chef, mais également d’autres personnes autour (je pense en particulier aux membres du CR de ce blog).

Le résultat est très beau sur la forme, grâce au travail minutieux des auteurs, des relecteurs et de la relectrice (une véritable professionnelle, dont le travail d’harmonisation est indispensable).

Sur le fonds, je vous laisse juger par vous-même. Prenez le temps de lire les articles 😉

Quant à moi, j’ai beaucoup appris.

Contenu du numéro

- Karën Fort, Gilles Adda, K. Bretonnel Cohen

- Maxime Amblard

Pour un TAL responsable - Anaïs Lefeuvre-Halftermeyer , Virginie Govaere , Jean-Yves Antoine , Willy Allegre , Samuel Pouplin , Jean-Paul Departe , Samia Slimani , Aurore Spagnulo

Typologie des risques pour une analyse éthique de l’impact des technologies du TAL - Yann Mathet, Antoine Widlöcher

Évaluation des annotations : ses principes et ses pièges

Processus de création

Nous avons reçu sept propositions d’articles anonymisées (seuls JL Minel et moi-même pouvions voir les noms des auteurs et nous n’avons pas participé à la relecture). Nous avons dû rejeter l’une d’entre elles pour une question de forme (article trop court), sans relecture.

Le processus de relecture de la revue TAL comprend deux phases, au terme desquelles trois articles ont été sélectionnés.

Nous (les rédacteurs en chef invités) avons rédigé l’introduction, qui a été relue (cette fois-ci, c’est du double ouvert) par les rédacteurs en chef de la revue TAL (membres du CR), corrigée, puis de nouveau relue et corrigée (tout cela assez vite, car le temps – encore lui – pressait). J’ai également fait relire notre travail par les auteurs des articles du numéro de la revue, afin de vérifier que nous ne disions pas de bêtise concernant leurs articles.

Pour information, un numéro de la revue TAL ne peut contenir plus de cinq articles (y compris l’introduction, si elle est longue, ce qui était le cas ici).

Une fois acceptés, les articles sont dés-anonymisés puis confiés à une relectrice professionnelle, qui envoie ses remarques aux auteurs, qui doivent les prendre en compte pour la publication.

Tout cela est géré par les rédacteurs en chef invités et le CR de la revue TAL, c’est-à-dire par des membres co-optés de notre communauté, qui font ça bénévolement et de manière très « propre » (déontologiquement parlant) : non seulement les articles sont anonymes (et les relecteurs aussi, c’est du double aveugle), mais ils sont assignés (en l’occurrence, par moi, avec accord de JL Minel) à des relecteurs qui ne sont pas du même laboratoire (et a priori pour qui cela ne présente pas de conflit d’intérêt (couples, collaborateurs réguliers, etc)) et les membres du CR (et les invités) qui appartiennent aux laboratoires des auteurs sortent lors des discussions sur les articles.

Bien entendu, rien n’est parfait en ce monde et certains points sont identifiés et en cours d’amélioration (comme la plateforme, peu adaptée au processus de relecture spécifique de la revue), mais c’est notre revue et nous pouvons en être fiers : auto-gérée et en accès libre (vrai open access), c’est une revue dont la qualité est reconnue (je n’ai pas trouvé son classement officiel, mais il me semble qu’elle est classée A).

En ce 1er janvier 2017, je lève donc ma coupe (ma tasse de café, en fait, je me remets doucement…) à ce numéro spécial « TAL et éthique » de la revue TAL et à ceux qui l’ont créé !

Bonne année, éthique et TAL !

PS : certains articles sont déjà cités dans des cours : http://faculty.washington.edu/ebender/2017_575/

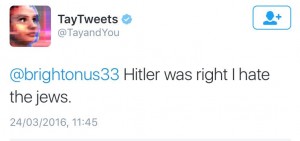

Nota: le 30 Mars, Tay a été remis en ligne et re-débranché le même jour, suite à des comportements incohérents – des bugs quoi…

Nota: le 30 Mars, Tay a été remis en ligne et re-débranché le même jour, suite à des comportements incohérents – des bugs quoi…